Motivation

用扩散模型还是LLM做视觉生成?:LLM相比于Diffusion的优势,基设好,模型架构统一,多任务友好。但是当前主流的视觉生成还是以扩散模型为主,主要的原因在于训练一个基础模型的成本很高,以SD开源模型为代表。基于开源SD进行优化实现成本小很多,通过各种adapter在下游任务做适配。扩散模型对于任意多模态生成不利于统一(比如,如何用扩散模型做QA问答?),LLM会更友好。

主要贡献

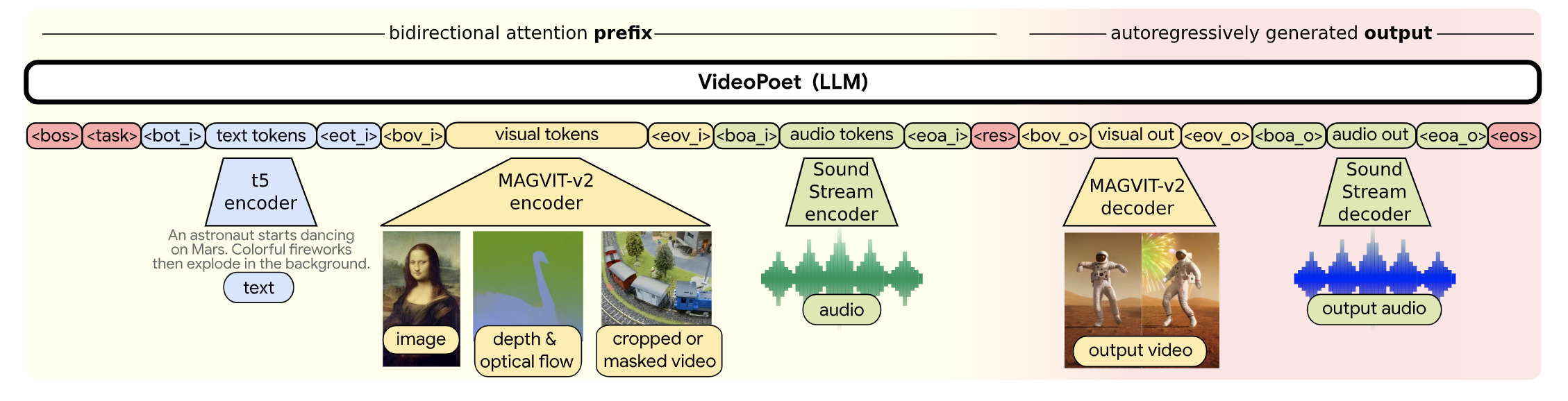

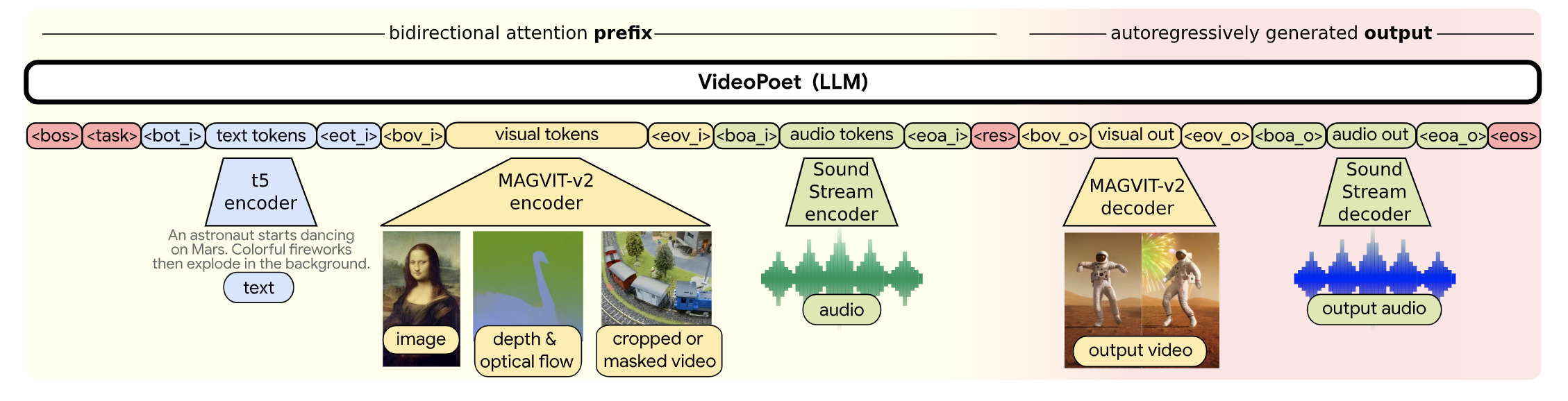

- 多模态生成统一架构,实现图片、视频、音频的自回归生成,其中文本采用T5,视觉采用Magvit-v2,音频采用SoundStream Encoder进行离散化

- 级连的两阶段超分(两个2x超分):超分辨率受限于token长度,采用局部窗口的attention方式。采用将水平、垂直、时间三个维度解耦。

一些细节

- 模型参数量:8B模型

- 语言模型选择:UL2: Unifying Language Learning Paradigms

- 图文数据量:1B

- 视频数据量:270M(其中100M带有文字描述)

- tokeinzer词表:视觉采用Magvit-v2【26w词表】、音频:SoundStream Encoder【4096词表】

一些思考

- 关于文本编码:只用64个Token进行文字编码,并且使用预训练的文本编码器(T5-XL)。虽然提高了效率,但是受限预训练模型,并且转换到中文场景也会有限制(中文语义编码不准确)。端到端训练时,能够训练文本编码,如果有足够的数据量,理论上应该是更适配的。另外,该设计方案不考虑文本生成,不太符合全模态输出的设计。

- 视觉Tokenizer:Tokenizer在整个框架中非常重要,提升压缩率,能用更少的token来表示,以提升自回归的效率。Tokenizer应该是分层级的,有些场景对细节要求很高,则需要非常低损失的压缩,如小人脸、文字。对于风景,需要压缩损失可以更大些,提升自回归的效率。

- 预训练任务+下游多任务Finetune: 预训练任务越多越丰富,在使用时zero-shot性能和需要的下游数据量越少。具体需要哪些预训练任务,需要仔细考量。

评论 (0)