生成内容真实度判别调研 & 模型选型

1. 背景概述

- 调研出发点: 利用判别模型对生成内容进行真假打分,根据模型输出属于“真”类的得分进行排序,可以筛选出生成“质量”更高的内容

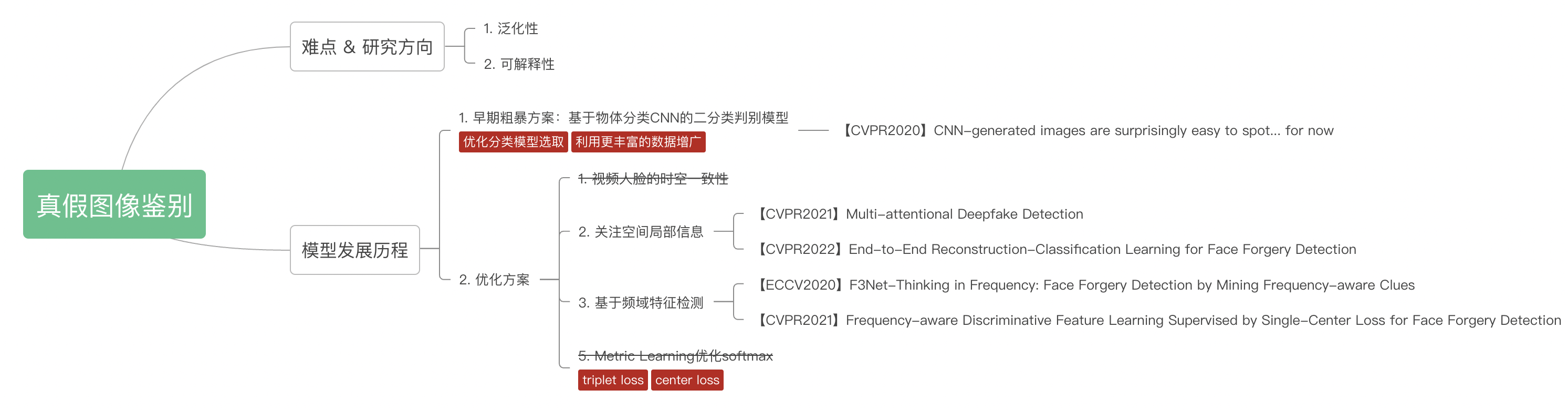

- 任务难点:

- 简单的二分类任务(真假判别),泛化性能不足(没学到期望的关键信息)

- 简单整图二分类模型的解释性不强。如果能够在空间上“检测”到不真实部分的位置,则模型的可解释性更强

本文主要围绕DeepFake相关工作和近期文本/图像生成模型和强化学习结合的Reward函数设计两方面展开调研

2. 相关工作

2.1 真假图像鉴别

2.1.1 粗暴二分类方案

【CVPR 2020】【Adobe Research】CNN-generated images are surprisingly easy to spot... for now

-

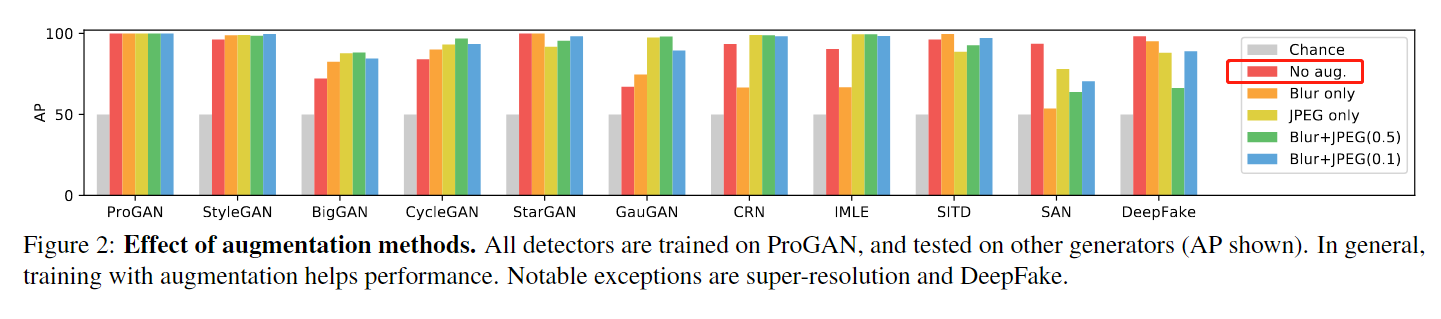

Motivation:提升真假鉴别器在不同数据集上的泛化性,实验分析影响模型泛化性的因素

-

Method & Results:

- 模型结构:利用ImageNet预训练的ResNet50进行真假鉴别二分类训练

- 数据增广:Gaussian blur、JPEG压缩的数据增广,提升模型在不同数据集下的泛化性能

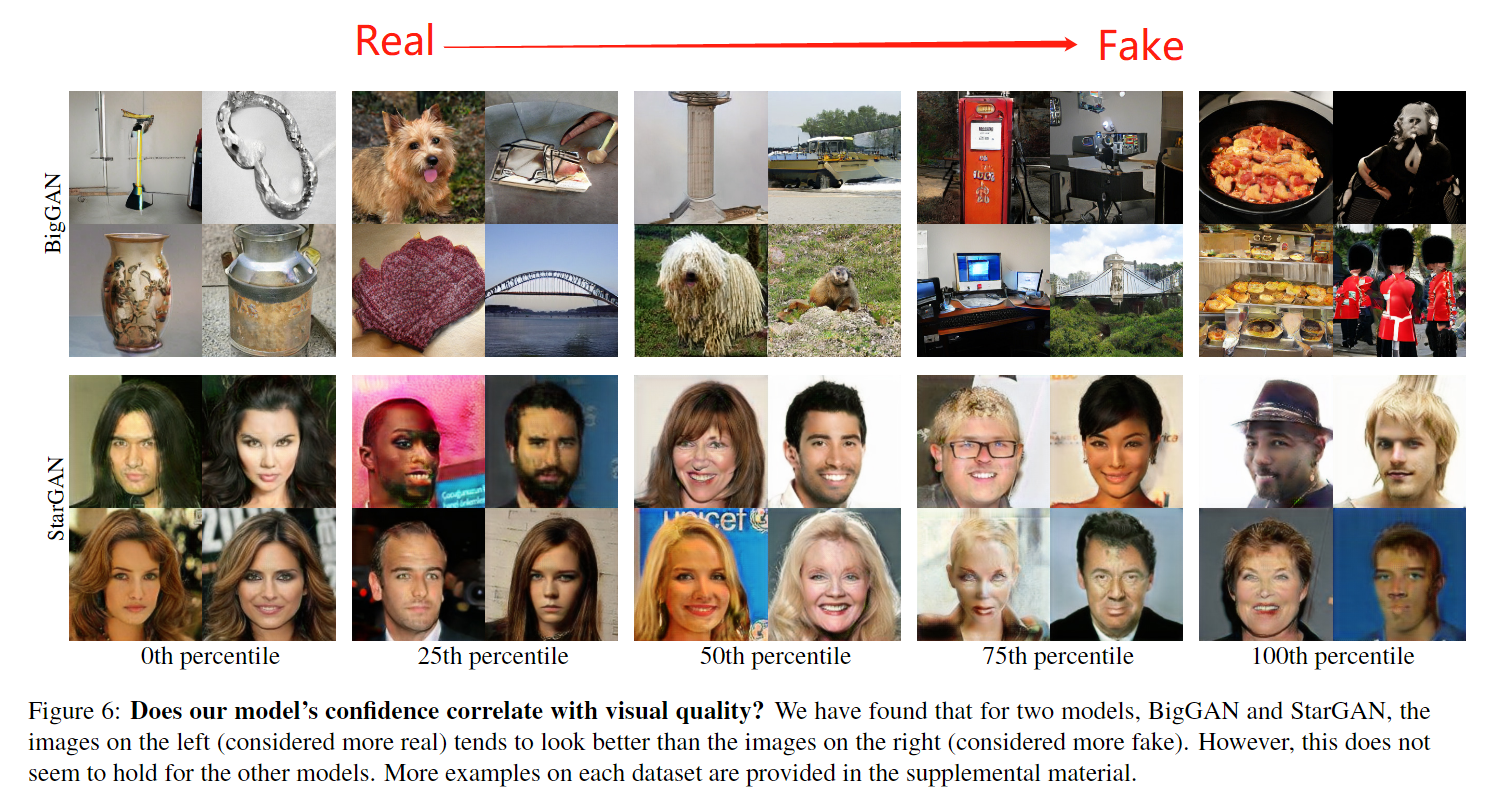

- 定性分析: 鉴别器不能稳定表征图像的真实度/虚假度,在部分数据集上可观测到规律

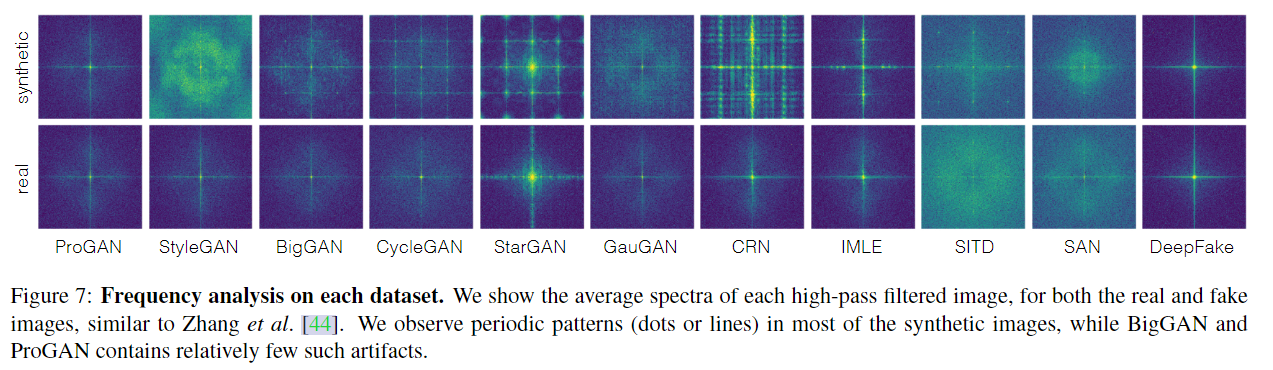

4. 生成图片 vs 真实图片频域差异:大部分生成图片在频域有棋盘效应(low-level CNN artifacts)

5. 在PS结果上的泛化性:模型在Photoshope处理过的数据集上预测结果近乎随机

2.1.2 关注局部细节的鉴别方法

【CVPR 2021】【Microsoft Cloud AI】Multi-attentional Deepfake Detection

- Motivation:真假图片分类和Fine-grained图片分类相似,更关注图像的局部细节,而不是整体轮廓 or 背景语义信息。借鉴Fine-grained classification中的part-based方法提升细节鉴别能力

- Method & Results:采用浅层纹理特征 & 深层语义特征融合的方式,进行二分类网络训练

- 局部边缘纹理增强模块(Texture enhancement block): 输入浅层特征Feature map,减去模糊(pooling)后的Feature mAP得到边缘纹理

- 空间局部注意力模块[Attnetion Module] & Bilinear Attention Pooling:输入高层语义特征,经过1x1卷积获得M个不同的Attention Map(Fk),利用这些注意力引导浅层&深层特征

- 增强注意力多样性:

- 基于注意力的显著性区域模糊AGDA(Attention Guided Data Augmentations):I′ = I × (1 − A) + Id × A (Id为高斯模糊图像,A为随机一张attention MAP)

- 注意力特征图metric learning约束(Regional Independence Loss):同一个注意力图关注区域特征相近,不同注意力图关注区域特征远离

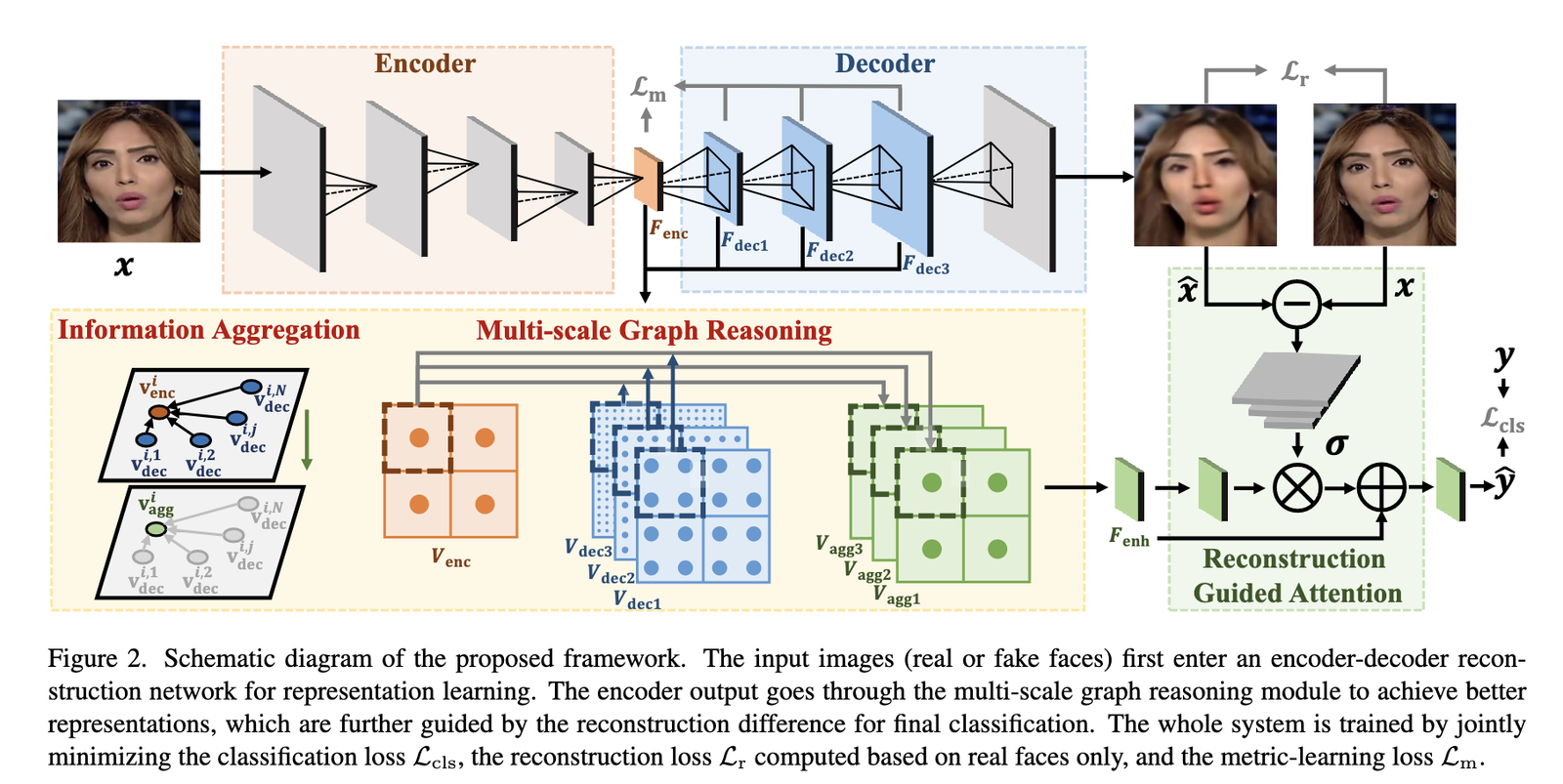

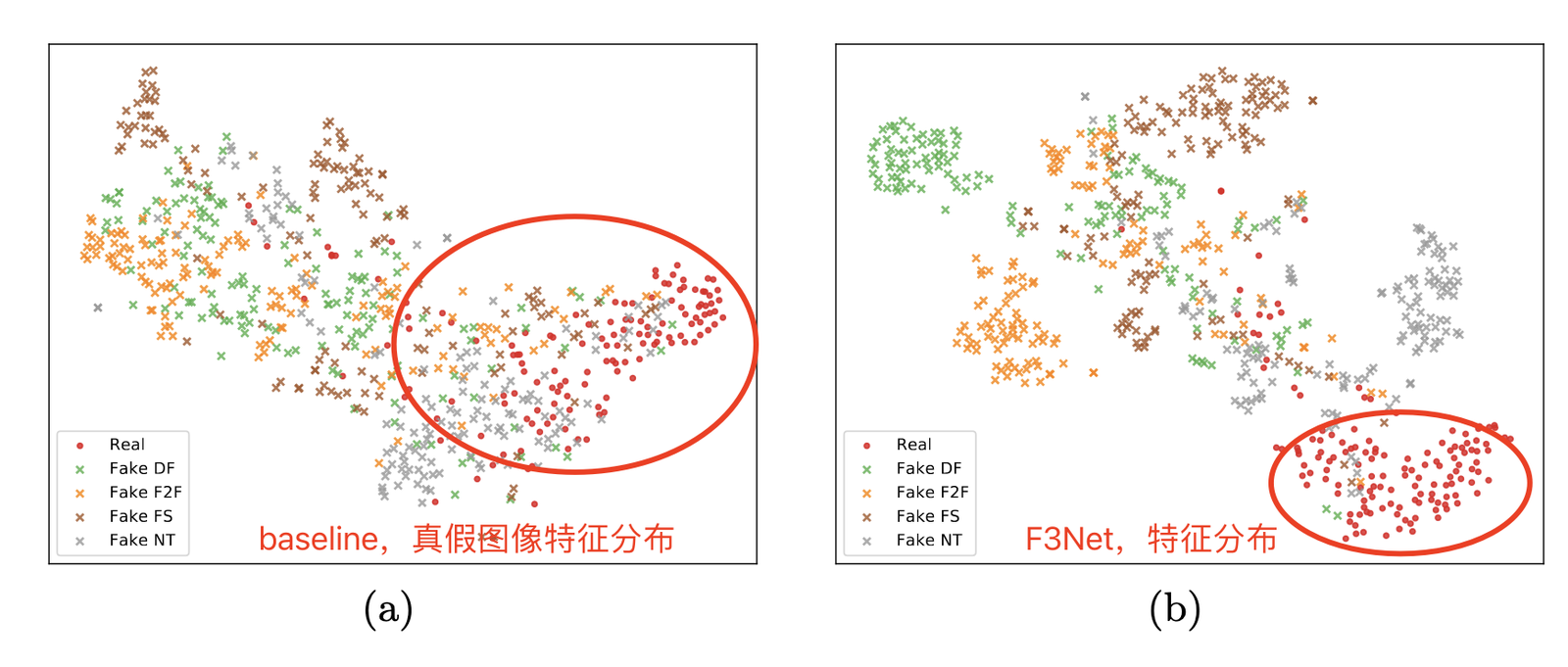

【CVPR 2022】【Youtu Lab, Tencent】End-to-End Reconstruction-Classification Learning for Face Forgery Detection

-

Motivation:当训练集中Fake类别图像分布不够丰富时(Fake图片的种类通常是多样且日益增长),判别式模型的泛化性能存在问题

-

Method & Results:通过生成式模型AutoEncoder进行像素级重建,学习真实图像的数据分布

- 模型结构优化:

- 像素级AutoEncoder重建(只对真实样本进行) & 重建误差注意力引导

- 在多个图像尺度下进行Encoder、Decoder之间的信息聚合:

- 度量学习损失优化:只约束真实样本特征之间尽可能接近(不同方法生成样本分布差异大),约束真假图像之间距离远离

- 模型泛化能力验证:训练不做数据扰动,测试时进数据增广,验证模型性能

- 模型结构优化:

2.1.3 基于频域的检测方法

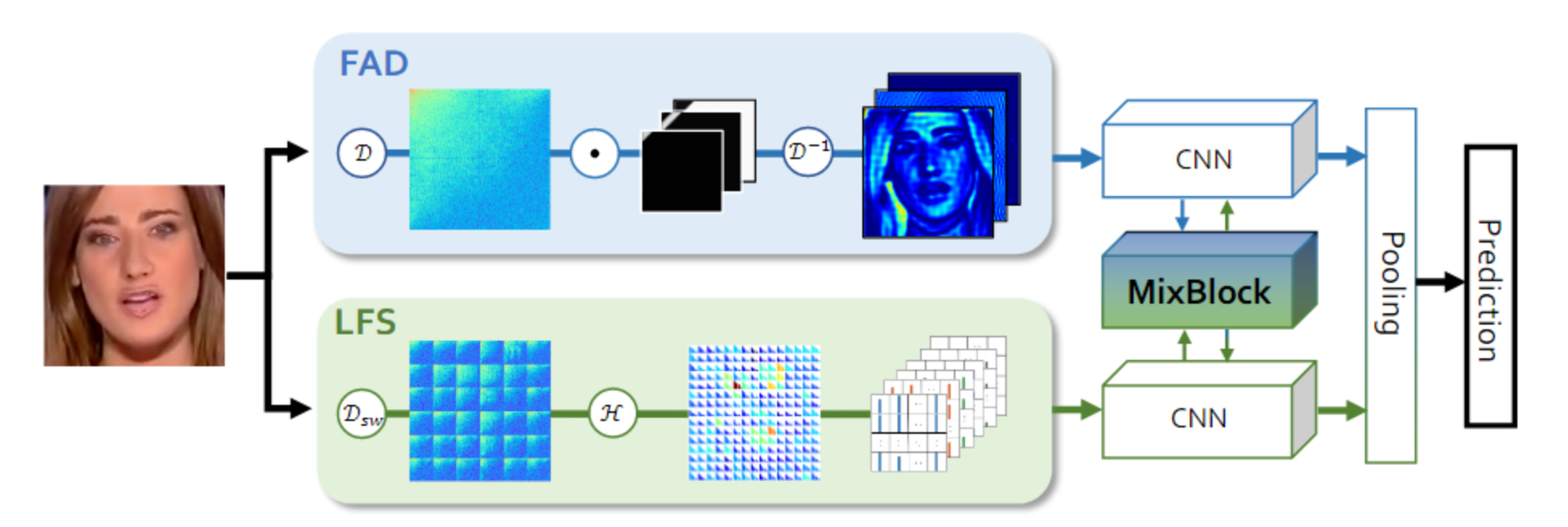

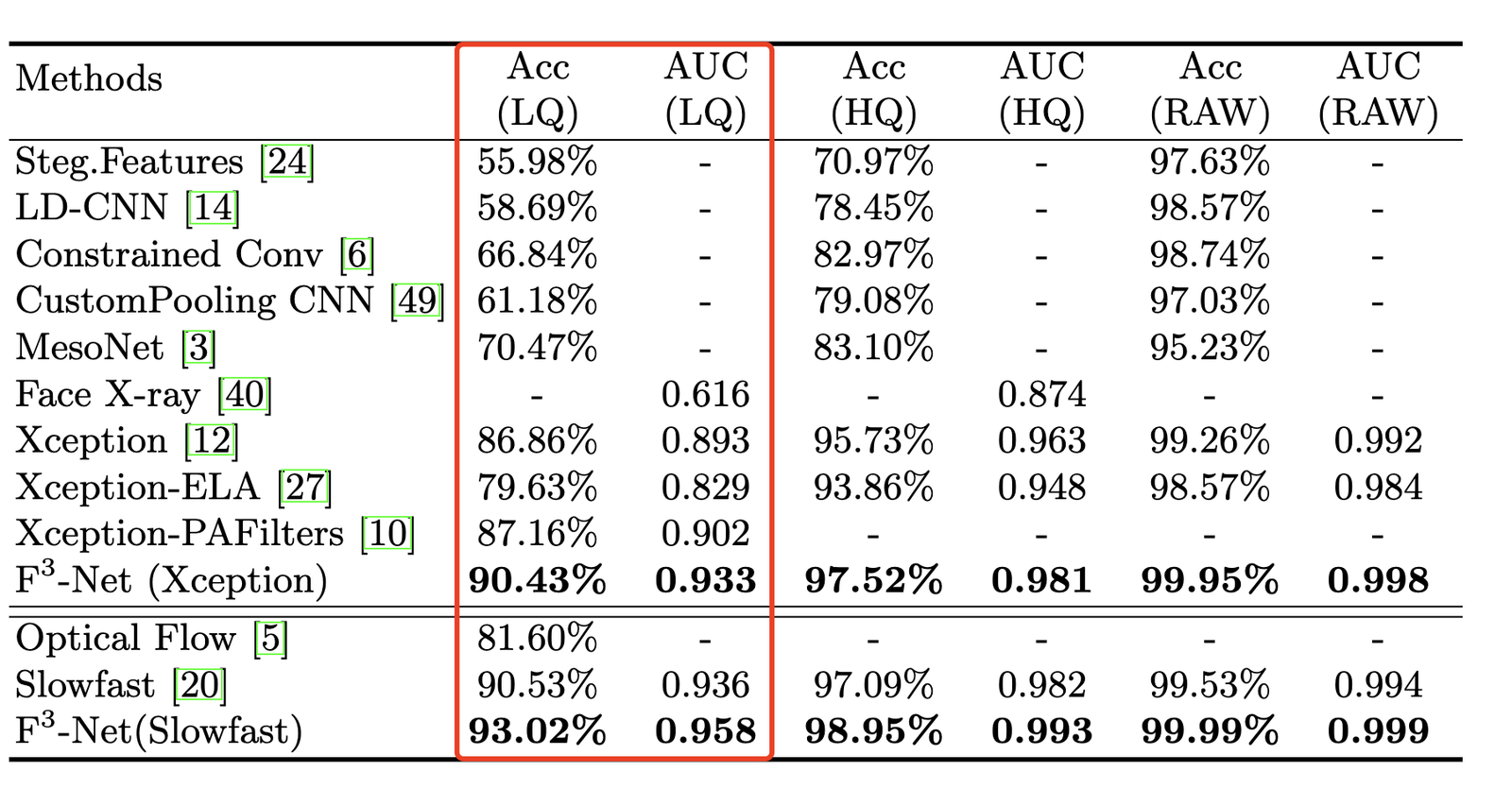

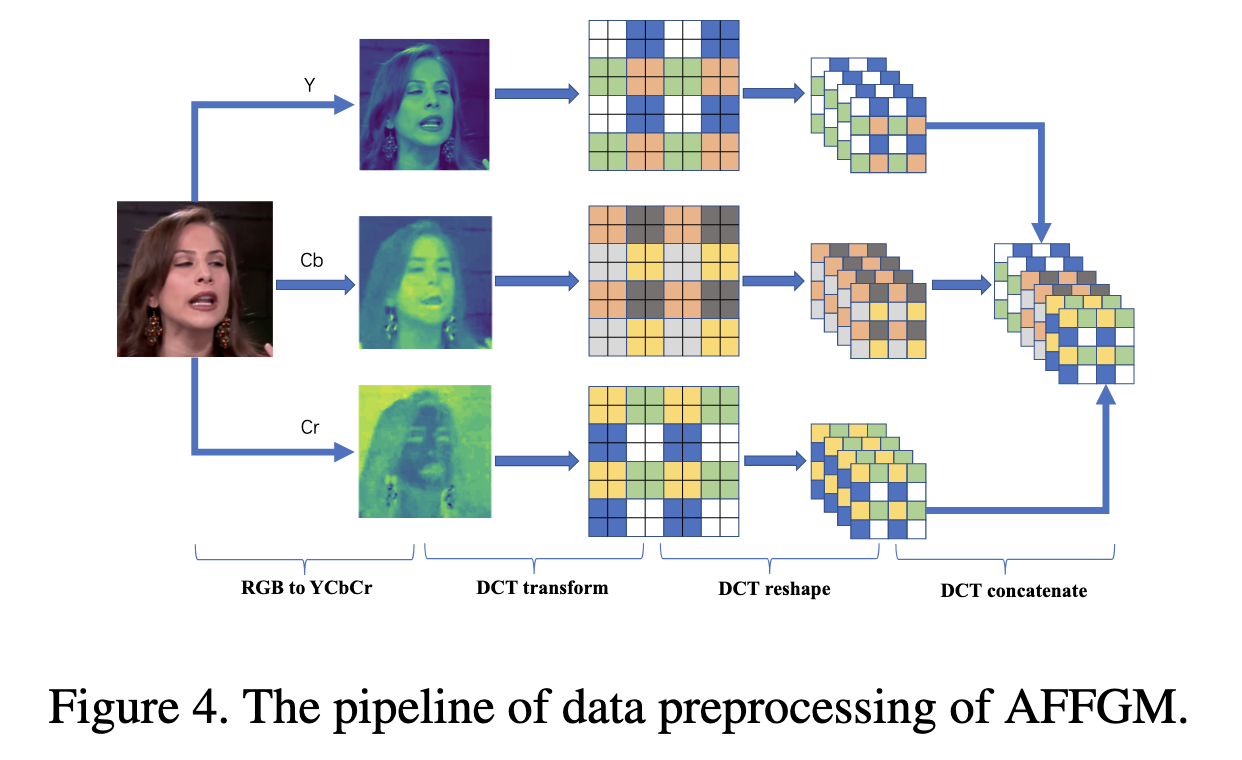

【ECCV 2020】【SenseTime】Thinking in Frequency: Face Forgery Detection by Mining Frequency-aware Clues

-

Motivation: 生成图像的“伪影”在频域更为明显,通过引入频域特征,提升模型鉴别能力;当图像被JPEG压缩后,伪影在像素空间上不显著,但在频域响应中可见

-

Method & Results:

论文方法整体还是一个二分类的框架,为了能够充分利用频域信息,作者采用了FAD提取空间域特征,LFS提取频域特征,最后再进行两类特征融合。

-

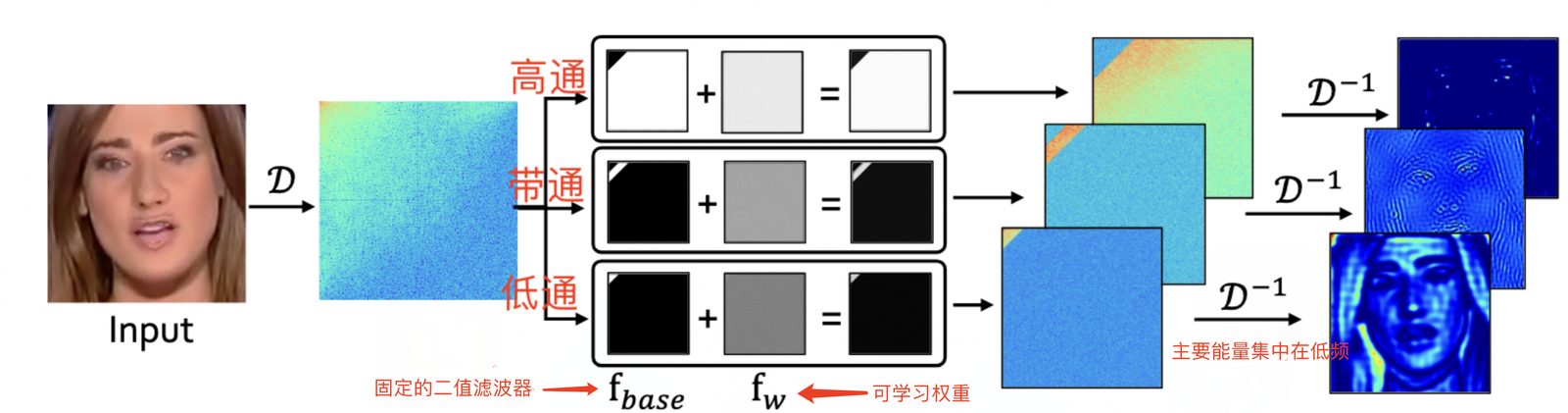

Frequency-aware 空间域特征(FAD):利用DCT将输入图像转换到频域,在频域进行高通、低通、和带通滤波,每个频带的滤波结果转换回空间域之后,就实现了图像分解,图像分解之后再进行CNN特征提取。

-

Local Frequency Statistics (LFS频域特征):利用滑动窗口DCT,对空间局部快进行频域分布统计特征

LFS 与FAD虽然都利用了频域信息,但是LFS是显式地以频域幅值作为特征,而FAD则通过DCT反变换回空间域再进行CNN特征提取。局部窗口统计特征 & 空间像素特征具有平移不变形,所以能适用CNN。(不直接在整图的频域上使用CNN)

-

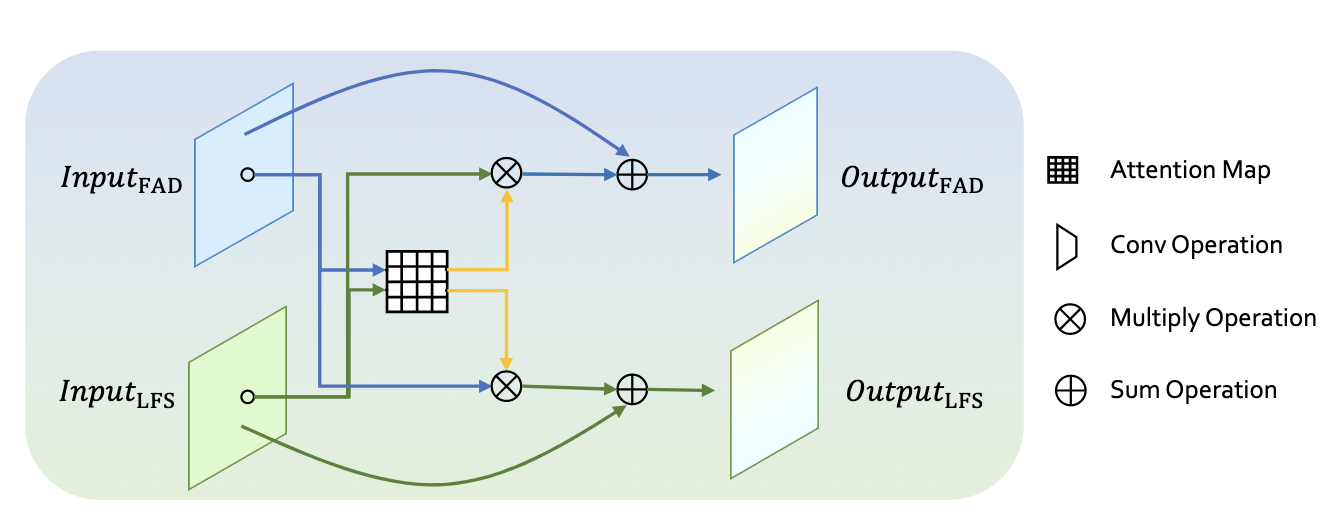

two-stream融合模块:Cross Attnetion 进行两类特征融合

-

模型优点 & 实验验证:在低画质图像上(压缩),模型的性能优越

-

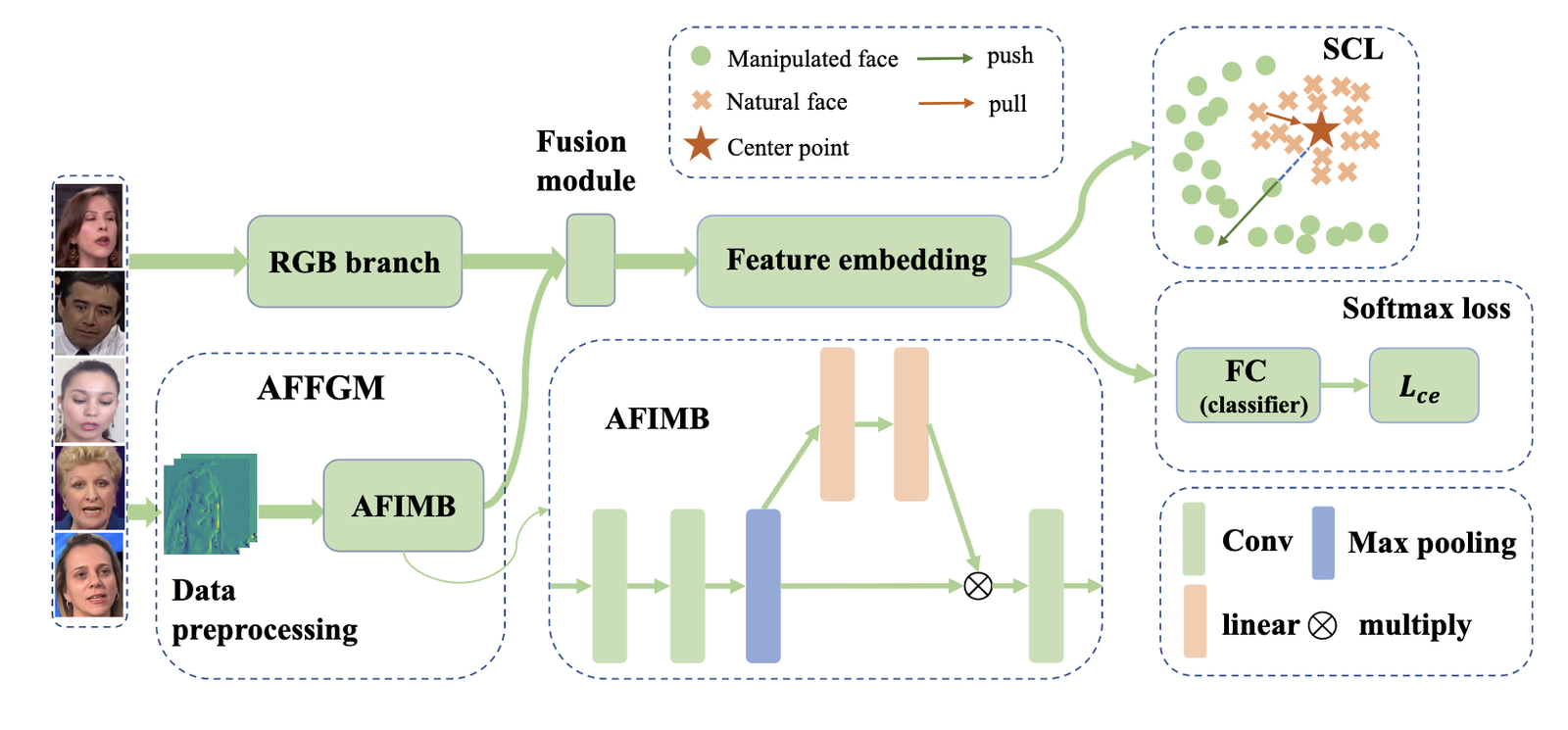

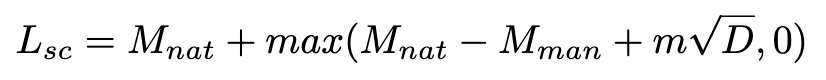

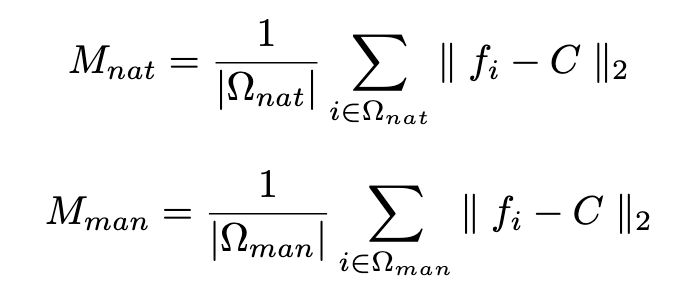

【CVPR 2021】【Kuaishou】Frequency-aware Discriminative Feature Learning Supervised by Single-Center Loss for Face Forgery Detection

- Motivation: 1)基于softmax的分类损失没有约束类内距离紧凑 & 类间距离尽可能远离,为了实现这一目标提升鉴别器模型的泛化能力,作者提出针对真假二分类的度量学习损失函数;2)频域与像素空间域特征互补,提升精度

- Method & Results:

模型整体流程:输入RGB图像,分别提取空间像素域和频域特征,对融合后的特征进行Softmax loss和Single-Center Loss两种损失函数进行监督:

- 频域特征提取:与JPEG压缩的方法类似,将RGB-〉YCbCr后,对局部块(8*8)进行DCT变换,并合并相同频率系数到当个channel(局部块 & reshape等操作和F3Net相似)

- Single-Center Loss:最小化真实图像特征与Natural(真实图像)类中心之间的距离 & 最大化,最大化每个生成图像与Natural类别中心之间的相对距离

- 模型效果验证:

- 频域特征提取:与JPEG压缩的方法类似,将RGB-〉YCbCr后,对局部块(8*8)进行DCT变换,并合并相同频率系数到当个channel(局部块 & reshape等操作和F3Net相似)

2.2 生成内容排序

2.2.1 文本生成

【InstructGPT】【OpenAI】Training language models to follow instructions with human feedback

- Reward Model方法:对于一个prompt生成N个结果,让标注员对生成内容进行排序。对于一条排序好的标注数据,选择组样本对,并构建pairwise网络,学习对选择的两个生成内容进行质量高低判断。不做绝对打分而做排序的原因:排序标注更容易达成一致意见,标准更统一,而打绝对分数标注更困难(进而导致标注质量低,模型训练困难)。

2.2.2 图片生成

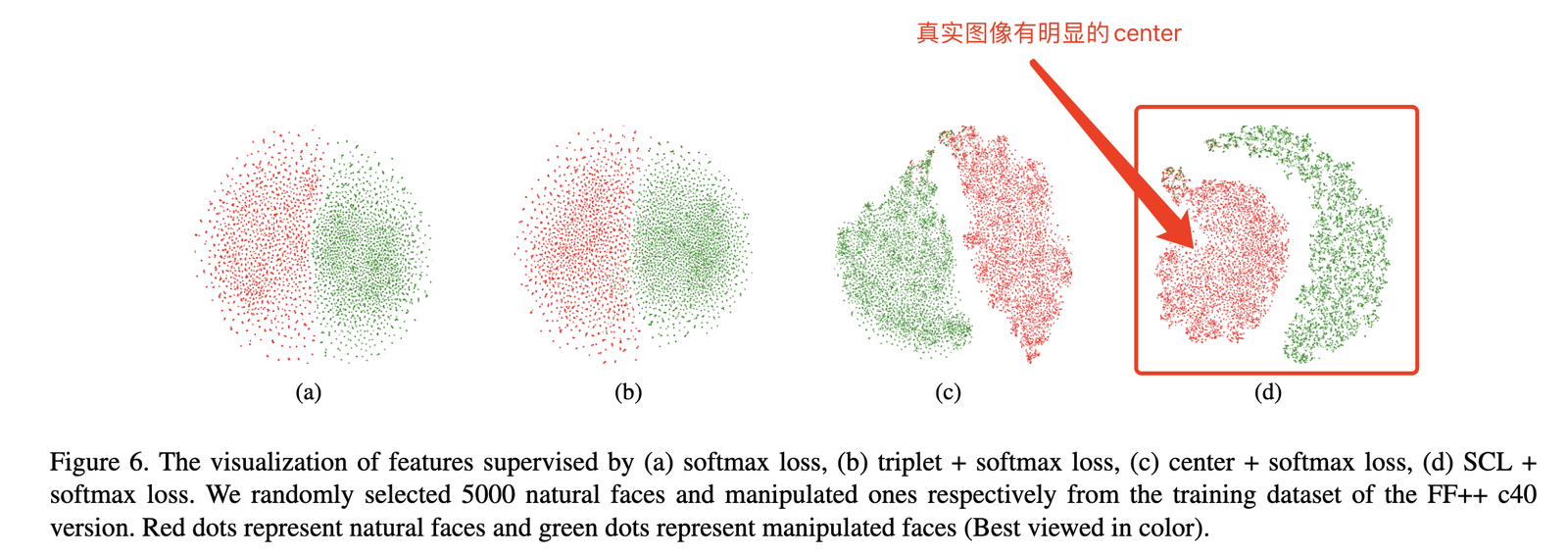

【Google】 Aligning Text-to-Image Models using Human Feedback

- Reward Function:学习文本与生成图像之间的匹配程度,采用0/1二分进行监督(背景/计数/颜色三方面综合考量)

- 模型输入:prompt T + 生成图像 I

- 模型输出:利用clip的文本 & 视觉 encoder分别提取文本和图像特征,经过两层MLP直接输出匹配度

- 监督目标:监督信号包含有监督和自监督两种

- 有监督:Reward模型输出的匹配度与人工标注的0/1匹配值,进行MSEloss监督

- 自监督:随机采样N个文本与生成图像I计算匹配度,最后得到N+1个匹配度score,进行CrossEntropy损失函数监督

评论 (0)